AI模型部署与运维策略

随着人工智能技术的快速发展,模型部署与运维已成为AI应用落地的关键环节。一个成功的AI系统不仅需要高质量的模型,更需要稳定、高效、可扩展的部署策略和完善的运维体系。本文将深入探讨AI模型部署与运维的最佳实践,帮助构建可靠的AI服务基础设施。

模型部署基础架构

模型部署是将训练好的AI模型转化为可对外提供服务的过程。现代AI系统通常采用微服务架构,将模型封装为独立的服务单元,通过API接口对外提供功能。这种架构具有高内聚、低耦合的特点,便于独立开发和部署。

部署模式选择

根据业务需求和基础设施条件,AI模型部署主要有以下几种模式:

- 本地部署:将模型部署在本地服务器或边缘设备上,适用于低延迟、高隐私要求的场景,但需要承担硬件成本和维护责任。

- 云端部署:利用云服务提供商的AI平台,如AWS SageMaker、Google AI Platform或Azure Machine Learning,实现弹性扩展和按需付费。

- 混合部署:结合本地和云端的优势,将核心模型部署在本地,辅助服务部署在云端,平衡性能和成本。

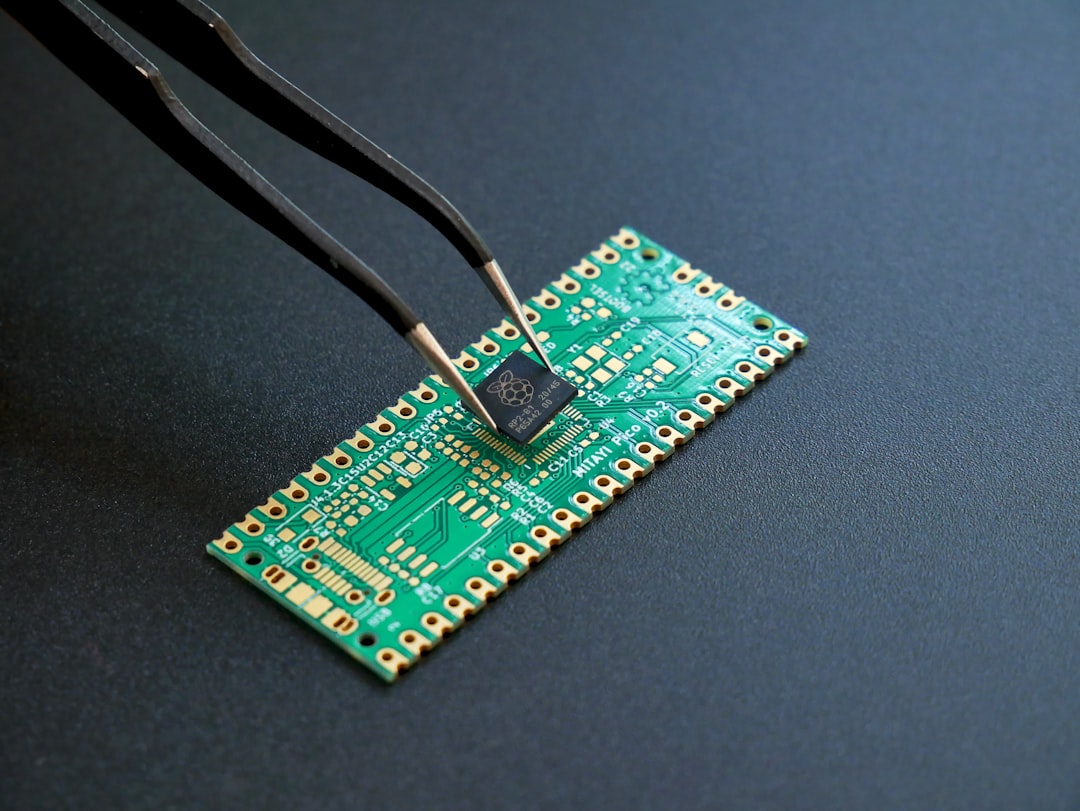

- 边缘部署:在IoT设备或边缘计算节点部署轻量级模型,适用于实时性要求高的场景,如自动驾驶、工业检测等。

容器化与编排技术

Docker容器技术已成为AI模型部署的标准实践,通过容器化可以实现环境一致性、资源隔离和快速部署。配合Kubernetes等编排工具,可以实现自动扩缩容、故障恢复和服务发现等功能。

对于GPU密集型AI模型,需要特别关注容器中的GPU资源配置。NVIDIA Container Toolkit提供了GPU支持,确保容器能够访问底层GPU资源。同时,需要合理设置GPU资源限制,避免资源争用导致性能下降。

部署策略与最佳实践

蓝绿部署与金丝雀发布

为了确保模型更新过程平滑过渡,避免服务中断,推荐采用蓝绿部署或金丝雀发布策略:

- 蓝绿部署:维护两套完全相同的生产环境(蓝环境和绿环境)。新模型先部署到绿环境,经过充分测试后,将流量从蓝环境切换到绿环境。这种策略可以实现零停机更新,但需要双倍资源。

- 金丝雀发布:逐步将流量导向新版本模型。先让少量用户使用新版本,验证无误后逐步扩大流量比例。这种策略资源利用率高,风险可控,适合A/B测试场景。

模型版本管理

完善的模型版本管理是AI系统运维的基础。建议采用以下策略:

- 使用MLflow或Weights & Biases等工具记录模型元数据、性能指标和训练环境。

- 建立模型注册表,存储不同版本的模型文件和配置。

- 实现模型热更新机制,无需重启服务即可加载新模型。

- 保留历史版本支持回滚操作,应对突发问题。

依赖管理

AI模型通常依赖复杂的软件栈,包括深度学习框架、数据处理库和系统组件。依赖管理不当可能导致部署失败或运行时错误。建议采用以下措施:

- 使用虚拟环境隔离不同项目的依赖。

- 在容器镜像中固定依赖版本,确保环境一致性。

- 定期更新依赖包,修复安全漏洞,避免兼容性问题。

- 建立依赖冲突检测机制,提前发现潜在问题。

运维监控体系

监控指标设计

全面的监控是保障AI系统稳定运行的关键。监控指标应涵盖以下维度:

- 性能指标:请求响应时间、吞吐量、错误率、资源利用率(CPU、内存、GPU)等。

- 业务指标:模型预测准确率、召回率、F1分数等,以及业务相关的KPI。

- 系统指标:服务可用性、日志错误率、磁盘空间、网络流量等。

- 模型指标:模型漂移程度、特征分布变化、预测置信度等。

日志与追踪

结构化日志和分布式追踪对于问题定位至关重要:

- 采用JSON格式记录日志,便于解析和分析。

- 为每个请求分配唯一追踪ID,实现端到端追踪。

- 记录关键决策点和模型推理过程,支持离线分析。

- 建立日志聚合系统,实现集中存储和快速检索。

告警机制

智能告警系统可以及时发现潜在问题:

- 基于历史数据设置合理的阈值,避免误报。

- 采用多级告警策略,区分严重程度。

- 实现告警收敛机制,避免重复通知。

- 建立告警升级流程,确保关键问题得到及时处理。

性能优化策略

模型优化技术

在生产环境中,模型性能直接影响用户体验和运营成本。常用的优化技术包括:

- 模型压缩:通过量化、剪枝、知识蒸馏等技术减小模型体积。

- 批处理推理:合并多个请求进行批量推理,提高GPU利用率。

- 模型并行:对于大模型,采用模型并行技术拆分计算任务。

- 算子融合:合并多个计算操作,减少内存访问和计算开销。

资源调度优化

合理配置计算资源是提高系统效率的关键:

- 根据模型特性选择合适的实例类型,如CPU、GPU或TPU。

- 实现自动扩缩容,根据负载动态调整资源。

- 使用GPU共享技术,提高多任务场景下的资源利用率。

- 优化数据预处理流水线,减少模型等待时间。

缓存策略

缓存可以显著提高响应速度,降低计算负载:

- 对高频查询结果进行缓存,避免重复计算。

- 实现智能缓存失效策略,确保数据一致性。

- 采用多级缓存架构,平衡内存和存储需求。

- 监控缓存命中率,优化缓存配置。

安全与合规管理

数据安全

AI系统处理的数据往往包含敏感信息,需要严格保护:

- 实施数据加密,包括传输加密和存储加密。

- 建立数据访问控制机制,基于最小权限原则。

- 定期进行数据安全审计,发现潜在风险。

- 实现数据脱敏技术,保护用户隐私。

模型安全

模型本身也可能面临安全威胁:

- 防范对抗攻击,对输入数据进行预处理和验证。

- 保护模型知识产权,防止模型窃取。

- 监控模型异常行为,检测潜在的安全漏洞。

- 建立模型安全评估流程,确保模型符合安全标准。

合规性管理

随着AI监管日益严格,合规性成为必须考虑的因素:

- 确保模型决策符合相关法律法规要求。

- 保留模型决策依据,支持审计和追溯。

- 建立模型影响评估机制,评估模型对社会的影响。

- 定期进行合规性检查,及时调整策略。

故障恢复与持续改进

容灾与备份

完善的容灾体系可以确保系统在故障时快速恢复:

- 建立多活架构,避免单点故障。

- 定期进行灾难恢复演练,验证应急预案。

- 实施模型和数据备份策略,支持快速恢复。

- 建立故障恢复SLA,明确恢复时间和业务影响。

持续集成与部署

CI/CD流水线可以提高部署效率,减少人为错误:

- 自动化测试流程,包括单元测试、集成测试和性能测试。

- 实现自动化的模型评估和部署流程。

- 建立部署门禁机制,确保质量达标。

- 实现部署回滚功能,快速应对问题。

持续监控与改进

AI系统需要持续优化和改进:

- 建立性能基线,定期评估系统表现。

- 收集用户反馈,识别改进机会。

- 实施A/B测试,验证优化效果。

- 建立知识库,记录经验教训和最佳实践。

案例分析:智能客服系统部署实践

某大型电商企业部署智能客服系统的实践案例值得借鉴。该系统采用微服务架构,将意图识别、实体抽取、对话管理等模块独立部署。通过Kubernetes实现容器编排,支持弹性扩缩容。监控系统采用Prometheus+Grafana方案,实时监控模型性能和系统状态。

在部署策略上,企业采用了渐进式发布策略,先在部分业务线进行试点,验证效果后再全面推广。同时建立了完善的模型版本管理机制,支持快速回滚。经过半年的运行,系统响应时间从最初的500ms优化到100ms以内,准确率提升了15%,显著降低了人工客服成本。

未来发展趋势

随着技术发展,AI模型部署与运维将呈现以下趋势:

- MLOps成熟化:MLOps将成为AI工程化的标准实践,实现从数据到模型的自动化流水线。

- 边缘计算普及:随着边缘设备性能提升,更多AI模型将部署在边缘端,实现实时响应。

- 自优化系统:AI系统将具备自我监控、自我诊断和自我优化的能力,减少人工干预。

- 可信AI发展:可解释性和公平性将成为模型部署的重要考量因素。

总之,AI模型部署与运维是一个系统工程,需要综合考虑技术、业务、安全等多个维度。通过采用合适的部署策略、完善的运维体系和持续优化机制,可以构建稳定、高效、可靠的AI服务,为企业创造更大价值。

发表回复