AI模型压缩与量化技术概述

随着深度学习技术的快速发展,AI模型变得越来越复杂和庞大。从早期的LeNet-5到现代的GPT系列模型,参数量从数万增长到数千亿,给计算资源、存储空间和能耗带来了巨大挑战。模型压缩与量化技术应运而生,成为解决这些问题的关键手段。这些技术能够在保持模型性能的同时,显著减少模型的体积和计算复杂度,使AI模型能够在资源受限的设备上高效运行。

模型压缩技术原理

压缩的必要性

现代深度学习模型面临着严峻的部署挑战。以GPT-3为例,其拥有1750亿参数,仅存储就需要约350GB空间,这对于大多数移动设备和边缘设备来说是不可接受的。此外,巨大的模型也意味着高昂的计算成本和能耗。模型压缩技术正是为了解决这些问题而发展起来的,主要包括剪枝、量化、知识蒸馏和低秩分解等方法。

模型压缩的主要方法

1. 参数剪枝技术

参数剪枝是最早提出的模型压缩方法之一,其核心思想是移除神经网络中冗余的参数。剪枝可以分为非结构化剪枝和结构化剪枝两种类型。非结构化剪枝可以精确地移除单个参数,但通常需要专门的硬件支持才能高效执行;结构化剪枝则移除整个通道或滤波器,虽然压缩率稍低,但可以直接在标准硬件上运行。

剪枝过程通常包括三个步骤:首先训练一个完整的基准模型;然后根据某种重要性准则(如权重绝对值、梯度信息等)识别并移除冗余参数;最后对剪枝后的模型进行微调以恢复性能。近年来,基于正则化的剪枝方法得到了广泛关注,通过在损失函数中加入L1正则项,可以自动实现稀疏化,无需手动设定剪枝率。

2. 知识蒸馏技术

知识蒸馏是一种模型压缩方法,由Hinton等人在2015年提出。其核心思想是将复杂的大模型(教师模型)的知识迁移到轻量级的小模型(学生模型)中。教师模型通常具有更好的性能,而学生模型则更小、更快。通过设计适当的蒸馏损失函数,学生模型可以学习到教师模型的决策边界和输出分布。

知识蒸馏的关键在于如何定义”知识”。常见的知识表示包括:软标签(教师模型的输出概率分布)、中间特征表示和注意力机制等。例如,在图像分类任务中,学生模型可以学习教师模型对不同类别的置信度,而不仅仅是最终的预测结果。这种方法使得小模型能够获得类似大模型的泛化能力。

3. 低秩分解技术

低秩分解技术基于矩阵分解理论,假设神经网络中的权重矩阵可以分解为多个低秩矩阵的乘积。对于全连接层,可以将权重矩阵W分解为两个较小的矩阵U和V的乘积,即W≈UV。对于卷积层,可以使用Tucker分解或CP分解等方法将四维张量分解为多个低维张量的组合。

低秩分解的优势在于可以显著减少参数数量,同时保持模型的表达能力。例如,一个1000×1000的权重矩阵可以分解为1000×r和r×1000的两个矩阵,当r较小时(如r=100),参数量可以减少90%。然而,低秩分解可能会影响模型的某些特性,因此需要仔细选择秩的大小和分解方法。

量化技术详解

量化的基本原理

量化是将模型的浮点数参数转换为低精度表示(如8位整数、4位整数甚至二进制)的技术。通过减少每个参数的比特数,量化可以显著减小模型大小,同时加快计算速度并降低能耗。量化可以分为感知量化和后训练量化两种主要方法。

感知量化在模型训练过程中进行,通过在损失函数中加入量化-反量化操作,使模型学习到对量化不敏感的表示。这种方法通常能获得更好的性能,但需要重新训练模型。后训练量化则是在训练完成后直接对模型进行量化,无需重新训练,实现简单但可能会有一定的性能损失。

量化方法分类

1. 对称量化

对称量化是量化中最常用的方法之一,其特点是零点为零,量化范围关于原点对称。在对称量化中,浮点数x与量化整数q之间的转换关系为:q = round(x/s),其中s是缩放因子。反量化过程则为:x = q×s。

对称量化的优势在于实现简单,计算高效,特别适合激活值对称分布的情况(如ReLU激活函数的输出)。然而,对于非对称分布的数据,对称量化可能会导致量化误差较大。此外,对称量化需要额外的硬件支持来处理有符号数运算。

2. 非对称量化

非对称量化引入了零点概念,可以更好地适应数据的实际分布。转换关系为:q = round((x-z)/s),其中z是零点,s是缩放因子。反量化过程为:x = q×s + z。非对称量化可以更精确地表示数据的分布,特别是当数据分布偏向某个特定范围时。

非对称量化的优势在于量化精度通常高于对称量化,特别适合权重和激活值分布不均匀的情况。然而,非对称量化需要额外的存储空间来存储零点,并且在计算时需要更多的操作,可能会影响推理速度。在实际应用中,通常会对权重使用对称量化,对激活值使用非对称量化,以平衡精度和效率。

3. 动态量化与静态量化

根据量化时机不同,可以分为动态量化和静态量化。动态量化在推理时进行,每次计算都需要重新计算缩放因子和零点,灵活性高但计算开销大。静态量化则是在量化阶段预先计算好所有参数的量化信息,推理时直接使用,速度更快但需要额外的校准数据集。

静态量化通常使用校准数据集来确定量化参数,常用的校准方法包括最小值-最大值校准、直方图校准和熵校准等。这些方法各有优缺点:最小值-最大值校准简单但可能受异常值影响;直方图校准更鲁棒但计算复杂;熵校准则试图保持量化前后信息分布的一致性。

压缩与量化的组合应用

混合压缩策略

在实际应用中,通常会将多种压缩技术组合使用,以获得更好的压缩效果。例如,可以先对模型进行剪枝,移除冗余参数,然后再对剩余参数进行量化;或者先进行知识蒸馏得到小模型,再对蒸馏后的模型进行量化。这种组合策略可以充分发挥各种技术的优势,弥补各自的不足。

一个典型的混合压缩流程可能包括:首先使用L1正则化训练一个稀疏模型;然后对模型进行通道剪枝,移除不重要的通道;接着使用知识蒸馏将知识迁移到更小的模型;最后对模型进行8位量化。通过这样的组合,可以在保持较高精度的同时实现10倍以上的压缩率。

硬件感知的压缩方法

不同的硬件平台对压缩模型的支持程度不同,因此在设计压缩策略时需要考虑目标硬件的特性。例如,移动设备通常对整数运算有很好的优化,因此量化在这些设备上效果显著;而某些专用的AI芯片可能支持特定的稀疏格式,针对这些硬件设计的剪枝方法可以更好地发挥性能。

硬件感知的压缩方法通常包括硬件感知的剪枝、硬件友好的量化和针对特定硬件的优化等。例如,为GPU设计的剪枝方法倾向于保持张量的连续性,以充分利用GPU的并行计算能力;而为NPU设计的量化方法则可能使用特殊的量化格式,以匹配NPU的指令集。

性能评估与优化

压缩效果的评估指标

评估压缩效果需要综合考虑多个指标,包括模型大小、计算量、推理速度、内存占用和精度损失等。模型大小直接影响存储需求,计算量(通常以FLOPs衡量)影响计算时间,推理速度和内存占用则反映了实际部署时的性能,而精度损失是评估压缩是否成功的关键指标。

常用的评估方法包括:参数压缩率(压缩后参数量/原始参数量)、计算加速比(原始计算时间/压缩后计算时间)、精度保持率(压缩后精度/原始精度)等。在实际应用中,通常需要在这些指标之间进行权衡,找到最适合特定应用场景的压缩方案。

精度恢复技术

压缩和量化过程不可避免地会导致模型精度下降,因此需要采用各种技术来恢复精度。常见的精度恢复方法包括:精细调优(使用较小的学习率和更多的训练轮次)、渐进式训练(逐步增加剪枝率或量化比特数)、正则化技术(如权重衰减、dropout等)和集成学习等。

近年来,基于元学习的精度恢复方法受到了广泛关注。这种方法通过学习如何快速适应压缩带来的变化,可以显著减少微调所需的数据和计算资源。此外,一些研究还探索了自动化的压缩方法,通过强化学习或神经架构搜索等技术,自动找到最优的压缩方案。

实际应用案例

移动端应用

在移动设备上,模型压缩和量化技术得到了广泛应用。例如,Google的MobileNet系列模型通过深度可分离卷积和量化技术,在保持较高精度的同时实现了实时推理。Facebook的DenseNet则通过密集连接和剪枝技术,在有限的内存下实现了优异的性能。

实际案例显示,通过适当的压缩和量化,ResNet-50模型在ImageNet上的精度仅下降1-2%,但模型大小可以减小到原来的1/4,推理速度提升2-3倍。这使得原本无法在手机上运行的复杂模型能够流畅运行,极大地扩展了AI应用的可能性。

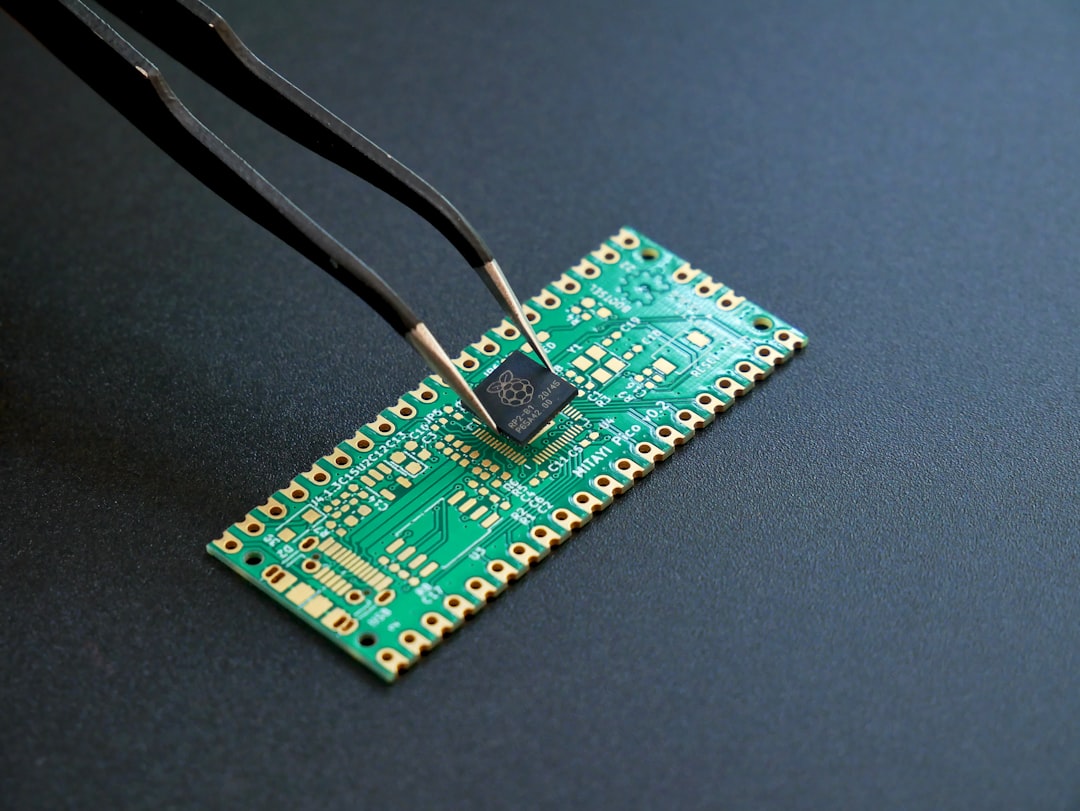

边缘计算设备

在物联网和边缘计算设备中,资源更加有限,模型压缩的需求更为迫切。例如,在智能摄像头中,通过模型压缩可以将人脸检测模型从几百MB减小到几MB,同时保持实时检测能力。在可穿戴设备中,压缩后的健康监测模型可以在低功耗处理器上高效运行,延长电池寿命。

边缘设备的压缩应用通常需要考虑特定的硬件约束。例如,在微控制器上运行的模型可能需要二值化(1位量化),而在FPGA上运行的模型则可以利用硬件友好的剪枝方法。这些针对特定硬件的优化使得AI技术能够在各种边缘设备上实现。

未来发展趋势

自动化压缩技术

未来的模型压缩将更加自动化和智能化。基于神经架构搜索(NAS)和自动机器学习(AutoML)的方法可以自动搜索最优的压缩方案,包括网络结构、剪枝策略和量化比特数等。这些方法能够根据具体任务和硬件约束,找到最优的压缩-精度平衡点。

此外,基于元学习和迁移学习的压缩方法也将得到发展。通过学习压缩的”元知识”,可以快速适应新的模型和任务,减少人工调参的工作量。这些技术将使得模型压缩变得更加简单和高效,降低AI技术的应用门槛。

新型量化方法

未来的量化技术将朝着更精细、更高效的方向发展。例如,混合精度量化将为不同层选择不同的量化比特数,重要层使用高精度,不重要的层使用低精度,从而在整体上保持精度。自适应量化则可以根据输入数据的动态特性,实时调整量化参数。

二值化网络(Binary Neural Networks)是量化技术的极端情况,将权重和激活值都量化为1位。虽然目前二值化网络的精度损失较大,但随着算法和硬件的发展,二值化网络有望在某些特定任务上取得突破。此外,基于神经科学的量化方法也将为量化技术带来新的思路。

结论

AI模型压缩与量化技术是推动AI技术普及的关键因素。通过剪枝、知识蒸馏、低秩分解和量化等方法,我们可以在保持模型性能的同时,显著减少模型的体积和计算复杂度。这些技术使得AI模型能够在资源受限的设备上高效运行,极大地扩展了AI技术的应用范围。

随着技术的发展,模型压缩将变得更加自动化和智能化,新的量化方法也将不断涌现。未来,模型压缩技术将与硬件设计、算法优化和系统架构等方面深度融合,共同构建高效、低功耗的AI系统。这些进步将使AI技术能够惠及更多人,推动人工智能在社会各个领域的广泛应用。

发表回复