Transformer架构深度解析

Transformer架构是近年来自然语言处理领域最具革命性的模型之一,由Google在2017年提出的论文《Attention Is All You Need》首次系统阐述。这一架构彻底改变了传统的序列处理方式,摒弃了循环神经网络(RNN)和长短期记忆网络(LSTM)等依赖序列顺序的模型,完全基于注意力机制来实现序列建模。

Transformer架构的背景与动机

在Transformer出现之前,序列处理任务主要依赖于RNN及其变体。然而,RNN存在几个关键问题:首先,RNN难以处理长距离依赖关系,因为信息在序列中传递时会逐渐衰减;其次,RNN是串行处理的,无法充分利用现代硬件的并行计算能力;最后,训练RNN容易出现梯度消失或梯度爆炸问题。

为了解决这些问题,研究人员开始探索注意力机制。注意力机制最初用于增强RNN的编码器-解码器架构,允许模型在生成输出时关注输入序列的不同部分。然而,完全基于注意力的Transformer架构展示了更强大的性能和更高的计算效率。

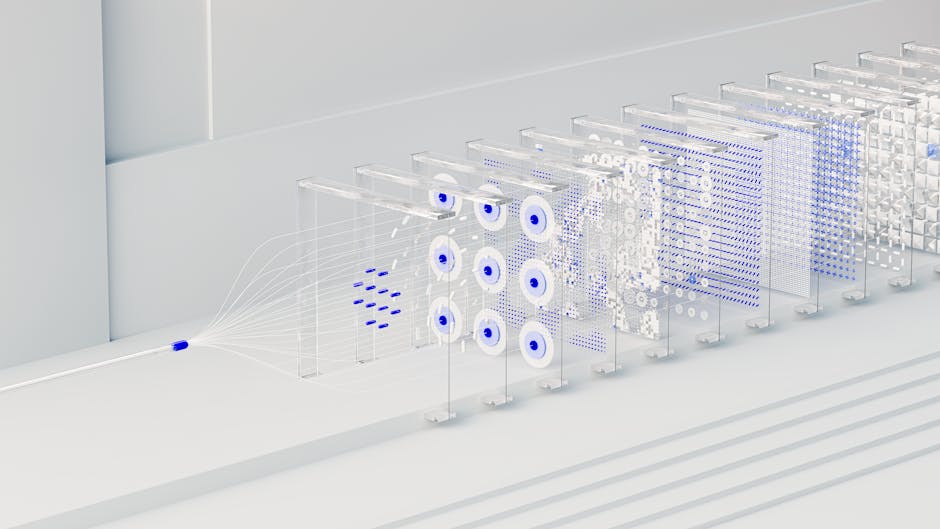

整体架构概览

Transformer模型采用编码器-解码器(Encoder-Decoder)架构,由多个相同的编码器层和解码器层堆叠而成。编码器负责处理输入序列,提取特征表示;解码器则根据编码器的输出和已经生成的序列,逐步生成输出序列。

编码器和解码器的核心组件都是多头注意力机制(Multi-Head Attention),此外还包括前馈神经网络(Feed-Forward Network)、残差连接(Residual Connection)和层归一化(Layer Normalization)等。这些组件共同构成了Transformer的基本构建块。

注意力机制的数学原理

注意力机制的核心思想是计算查询(Query)、键(Key)和值(Value)之间的相关性。给定一个查询Q和一组键值对(K, V),注意力权重计算如下:

Attention(Q, K, V) = softmax(QK^T/√d_k)V

其中,Q、K、V是通过将输入分别乘以不同的权重矩阵得到的。√d_k是缩放因子,用于防止点积过大导致softmax函数梯度消失。这个公式计算了查询Q与所有键K的相关性,然后对相应的值V进行加权求和。

在Transformer中,注意力机制不仅应用于输入序列的不同位置,还允许序列中的每个位置关注所有其他位置,实现了所谓的”自注意力”(Self-Attention)机制。

多头注意力机制

多头注意力机制是Transformer的核心创新之一。它将查询、键、值投影到h个不同的子空间,然后在每个子空间上并行计算注意力,最后将结果拼接并通过一个线性变换得到最终输出。

具体来说,多头注意力的计算过程如下:

- 将Q、K、V分别投影到h个不同的子空间:Q_i = QW_i^Q,K_i = KW_i^K,V_i = VW_i^V

- 在每个子空间上计算注意力:head_i = Attention(Q_i, K_i, V_i)

- 拼接所有子空间的结果:MultiHead(Q, K, V) = Concat(head_1, …, head_h)W^O

多头注意力允许模型同时关注不同位置和不同表示子空间的信息,增强了模型的表达能力。研究表明,多头注意力能够捕捉序列中的不同模式,如语法关系、语义关联等。

编码器结构详解

Transformer的编码器由N个相同的层堆叠而成,每层包含两个子层:

- 多头自注意力子层:处理输入序列,允许序列中的每个位置关注所有其他位置

- 前馈神经网络子层:由两个线性变换和一个ReLU激活函数组成,提供非线性变换能力

每个子层都采用残差连接和层归一化。具体来说,对于第i层的输入x_i,输出计算为:

LayerNorm(x_i + Sublayer(x_i))

残差连接有助于缓解深层网络的梯度消失问题,而层归一化则加速训练过程并提高模型稳定性。编码器通过堆叠多个这样的层,逐步提取输入序列的深层特征表示。

解码器结构详解

解码器同样由N个相同的层堆叠而成,但结构比编码器更复杂。每层包含三个子层:

- 带掩码的多头自注意力子层:防止当前位置关注未来的位置,确保自回归性质

- 编码器-解码器注意力子层:关注编码器的输出,结合编码器信息

- 前馈神经网络子层:与编码器中的前馈网络相同

在解码器的第一个子层中,”带掩码”的注意力机制确保在生成第t个位置时,只能关注前t-1个位置的信息。这是通过在softmax计算之前,将未来位置的注意力分数设置为负无穷实现的:

MaskedAttention(Q, K, V) = softmax(QK^T/√d_k + M)V

其中M是一个掩码矩阵,对于未来位置,M中的对应元素为负无穷。

位置编码

由于Transformer不包含任何递归或卷积结构,无法直接捕捉序列的顺序信息。为了解决这个问题,Transformer引入了位置编码(Positional Encoding),将位置信息注入到输入表示中。

位置编码使用正弦和余弦函数的组合来生成:

PE(pos, 2i) = sin(pos/10000^(2i/d_model))

PE(pos, 2i+1) = cos(pos/10000^(2i/d_model))

其中pos是位置索引,i是维度索引,d_model是模型的维度。这种位置编码具有以下优点:

- 能够处理任意长度的序列

- 具有确定性,便于模型学习位置模式

- 不同频率的正弦波可以编码不同尺度的位置信息

位置编码与输入嵌入相加,得到包含位置信息的最终输入表示。这种设计使得模型能够同时学习内容信息和位置信息。

残差连接与层归一化

残差连接和层归一化是Transformer能够成功训练深层网络的关键技术。残差连接允许信息直接从前一层传递到后一层,解决了梯度消失问题。层归一化则通过对每个样本的特征进行归一化,加速训练并提高模型稳定性。

在Transformer中,残差连接和层归一化的顺序也很重要。Transformer采用的是”残差连接后接层归一化”的结构,这与ResNet的”先归一化后残差”不同。研究表明,这种顺序在Transformer中效果更好。

层归一化的计算公式为:

LayerNorm(x) = γ * (x – μ) / √(σ² + ε) + β

其中μ是均值,σ²是方差,γ和β是可学习的缩放和平移参数,ε是一个很小的常数用于数值稳定性。

前馈神经网络

Transformer中的前馈神经网络是一个简单的两层全连接网络,包含一个ReLU激活函数。其结构为:

FFN(x) = max(0, xW1 + b1)W2 + b2

前馈网络的作用是为每个位置的特征提供非线性变换能力。由于前馈网络独立处理每个位置,可以并行计算,这符合Transformer的设计理念。

前馈网络的隐藏层维度通常是模型维度的4倍,即d_ff = 4 * d_model。较大的隐藏层容量允许模型学习更复杂的特征表示。

训练与优化策略

Transformer模型的训练采用了多种优化策略,这些策略对于模型的性能至关重要:

- 学习率预热:训练初期使用较小的学习率,然后线性增加到预设值,有助于稳定初期训练

- 学习率衰减:采用余弦退火或线性衰减策略,在训练后期逐步降低学习率

- 标签平滑:将硬标签转换为软标签,防止模型过度自信,提高泛化能力

- Dropout:在前馈网络和注意力子层之间添加dropout,防止过拟合

此外,Transformer还使用了Adam优化器,结合学习率预热和衰减策略,取得了良好的训练效果。批量大小通常较大(如4096或更大),充分利用GPU的并行计算能力。

Transformer的变体与发展

自Transformer提出以来,出现了许多重要的变体和发展:

- BERT:基于Transformer编码器,通过掩码语言建模和下一句预测任务进行预训练

- GPT系列:基于Transformer解码器,采用自回归方式生成文本

- T5:将所有NLP任务统一为文本到文本的格式

- ViT:将Transformer应用于计算机视觉领域,将图像分割成patch序列

- Efficient Transformers:提出各种优化策略,如稀疏注意力、线性注意力等,提高计算效率

这些变体展示了Transformer架构的强大适应性和广泛适用性,使其成为现代AI系统的核心组件。

实际应用与性能分析

Transformer架构在多个领域取得了突破性进展:

- 机器翻译:在WMT等基准测试上大幅超越传统方法

- 文本生成:在对话系统、摘要生成等任务上表现优异

- 问答系统:能够理解复杂问题并生成准确回答

- 代码生成:能够根据自然语言描述生成代码

- 多模态学习:结合文本、图像、音频等多种模态信息

Transformer的成功主要归功于其并行计算能力、长距离依赖建模能力和强大的表示学习能力。然而,它也存在一些挑战,如计算资源需求大、内存占用高等问题。

未来发展方向

尽管Transformer取得了巨大成功,但仍有多个值得探索的方向:

- 效率优化:开发更高效的注意力变体,如稀疏注意力、线性注意力等

- 长序列处理:改进位置编码机制,更好地处理超长序列

- 多模态融合:更好地整合不同模态的信息

- 知识增强:将外部知识融入Transformer架构

- 可解释性:提高模型决策过程的透明度和可解释性

随着研究的深入,Transformer架构将继续演进,并在更多领域发挥重要作用。同时,新的架构也可能出现,与Transformer形成互补或替代关系。

总之,Transformer架构代表了深度学习在序列建模领域的重大突破,其设计理念和实现方法对整个AI领域产生了深远影响。理解Transformer的原理和实现细节,对于从事自然语言处理、计算机视觉等相关领域的研究人员和工程师都具有重要意义。

发表回复