AI模型压缩与量化技术

随着深度学习技术的快速发展,AI模型在各个领域展现出强大的能力,但同时也面临着模型体积庞大、计算资源需求高的问题。为了将AI模型部署到资源受限的设备上,模型压缩与量化技术应运而生。这些技术能够在保持模型性能的同时,显著减少模型的大小和计算复杂度,为AI的边缘计算和移动应用提供了可能。

模型压缩的基本概念

模型压缩是指通过一系列技术手段,在不显著影响模型性能的前提下,减少模型的参数数量、计算量和存储空间。压缩技术主要分为四大类:量化、剪枝、知识蒸馏和低秩分解。每种技术都有其独特的优势和适用场景,在实际应用中往往需要多种技术结合使用,以达到最佳的压缩效果。

模型压缩的重要性体现在以下几个方面:

- 存储空间优化:压缩后的模型占用更少的存储空间,便于在移动设备和嵌入式系统上部署。

- 计算效率提升:减少计算量和内存访问次数,提高推理速度。

- 能耗降低:在移动设备和IoT设备上,降低功耗延长电池寿命。

- 硬件适配:使模型能够适配各种专用AI加速器。

量化技术

量化的基本原理

量化是将模型中的浮点数转换为低比特位表示的过程,例如从32位浮点数(FP32)转换为16位浮点数(FP16)或8位整数(INT8)。量化可以分为两种类型:对称量化和非对称量化。对称量化中,零点固定为0,而非对称量化则允许零点偏移。

量化的数学原理可以用以下公式表示:

对于对称量化:

quantize(x) = round(x / scale) + zero_point

dequantize(y) = (y – zero_point) * scale

其中,scale是缩放因子,zero_point是零点偏移量。

量化的实现方法

量化技术主要有以下几种实现方式:

- 后训练量化:在训练完成后对模型进行量化,不需要重新训练。

- 量化感知训练:在训练过程中模拟量化效果,使模型适应低精度表示。

- 动态量化:在推理时动态计算量化参数,适用于权重分布变化大的情况。

- 静态量化:在量化前确定量化参数,推理时直接使用。

量化带来的挑战

尽管量化能够显著减少模型大小,但也面临一些挑战:

- 精度损失:低精度表示可能导致模型精度下降。

- 硬件支持:并非所有硬件都支持低精度运算。

- 量化误差传播:在深层网络中,量化误差会累积放大。

剪枝技术

剪枝的基本概念

剪枝是通过移除模型中冗余的参数或神经元来减少模型大小的方法。剪枝可以分为结构化剪枝和非结构化剪枝。结构化剪枝移除整个神经元或通道,保持模型结构的规整性;非结构化剪枝则随机移除单个权重,可能导致稀疏矩阵。

剪枝策略

剪枝策略主要分为以下几类:

- 基于幅度的剪枝:移除权重值较小的连接。

- 基于梯度的剪枝:根据权重对模型损失的梯度大小进行剪枝。

- 基于一阶泰勒近似的剪枝:考虑权重变化对模型输出的影响。

- 基于重要性评分的剪枝:通过评估各部分的重要性进行剪枝。

剪枝的实现方法

剪枝的实现通常包括以下步骤:

- 训练基线模型:首先训练一个完整的模型作为基准。

- 确定剪枝准则:选择合适的剪枝策略和剪枝比例。

- 执行剪枝操作:根据准则移除冗余参数。

- 微调模型:对剪枝后的模型进行微调,恢复性能。

知识蒸馏

知识蒸馏的原理

知识蒸馏是一种将大模型(教师模型)的知识迁移到小模型(学生模型)的技术。其核心思想是让学生模型学习教师模型的软标签(概率分布),而不仅仅是硬标签(类别标签)。软标签包含了更多关于类别的相对信息,有助于学生模型学习到更鲁棒的特征表示。

蒸馏损失函数

知识蒸馏通常使用以下损失函数:

L = α * L_hard + (1-α) * L_soft

其中,L_hard是学生模型与真实标签的交叉熵损失,L_soft是学生模型与教师模型软标签的KL散度损失,α是平衡系数。

蒸馏的变体

知识蒸馏有多种变体:

- 在线蒸馏:教师模型和学生模型同时训练。

- 自蒸馏:使用模型自身的不同层作为教师。

- 数据无关蒸馏:不依赖标签信息进行蒸馏。

低秩分解

低秩分解的基本思想

低秩分解是将权重矩阵分解为多个低秩矩阵的乘积,从而减少参数数量。例如,将一个m×n的权重矩阵W分解为m×k和k×n两个矩阵的乘积,其中k远小于m和n。

矩阵分解方法

常用的矩阵分解方法包括:

- SVD分解:奇异值分解,将矩阵分解为正交矩阵和对角矩阵的乘积。

- Tucker分解:将高维张量分解为多个低维张量的乘积。

- CP分解:将张量分解为多个秩一张量的和。

低秩分解的训练

低秩分解的训练通常包括以下步骤:

- 初始化分解矩阵:随机初始化低秩矩阵。

- 前向传播:使用分解后的矩阵进行计算。

- 反向传播:计算梯度并更新分解矩阵。

- 迭代优化:重复前向和反向传播直到收敛。

混合精度量化

混合精度的概念

混合精度量化是指在网络的不同层使用不同的量化精度,例如,在关键层使用高精度,在非关键层使用低精度。这种方法能够在保持模型性能的同时,实现更好的压缩效果。

混合精度的实现策略

混合精度的实现策略包括:

- 基于敏感度的混合精度:根据各层对量化误差的敏感度分配精度。

- 基于硬件特性的混合精度:考虑目标硬件对不同精度的支持程度。

- 基于搜索的混合精度:通过搜索算法找到最优的精度分配方案。

混合精度的优势

混合精度量化的优势主要体现在:

- 更好的性能-压缩比:在相同压缩率下保持更好的性能。

- 硬件适配性:能够更好地适配不同硬件的特性。

- 灵活性:可以根据应用需求调整精度分配。

模型压缩的应用场景

移动端部署

在智能手机、平板等移动设备上,模型压缩技术使得复杂的AI模型能够本地运行,提高响应速度和保护用户隐私。例如,图像识别、语音助手等功能都可以通过压缩后的模型实现。

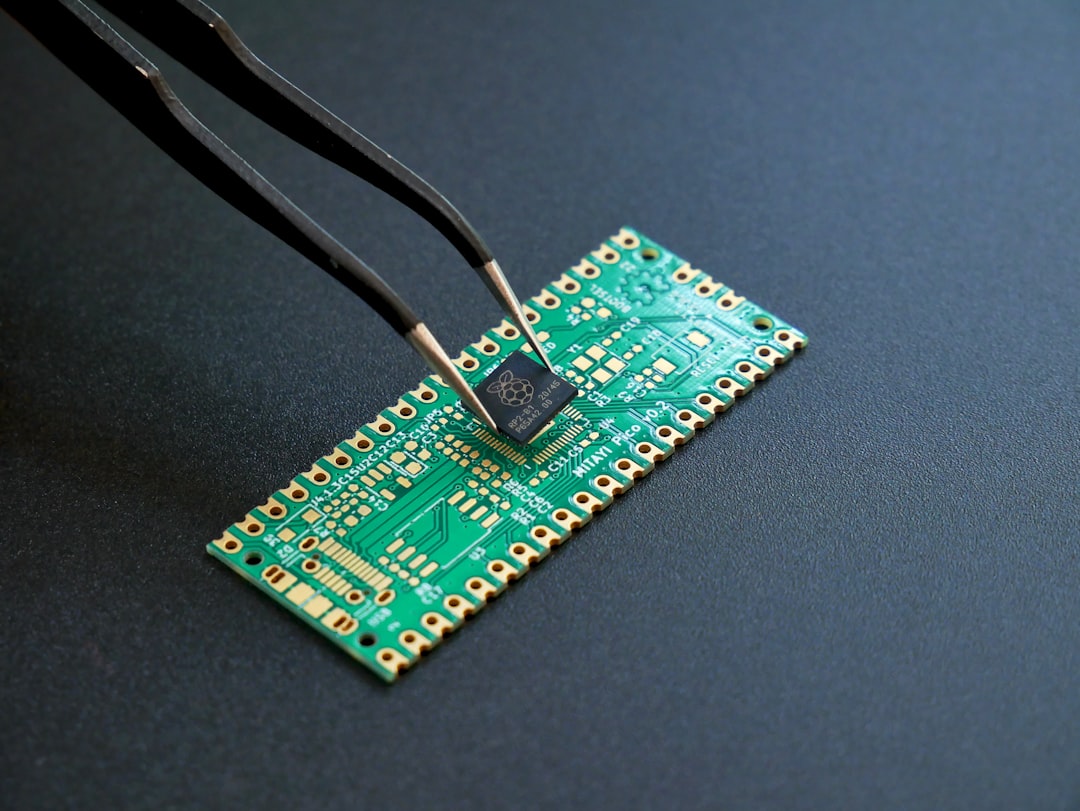

物联网设备

IoT设备通常资源有限,模型压缩技术使得这些设备能够运行本地AI推理,减少云端依赖,降低延迟和带宽消耗。智能家居、工业物联网等场景都需要高效的AI模型。

自动驾驶

自动驾驶系统需要在车载计算平台上实时运行复杂的感知算法,模型压缩技术能够在保证精度的前提下,提高推理速度,满足实时性要求。

边缘计算

在边缘计算场景中,模型压缩技术使得AI推理能够在靠近数据源的地方进行,减少数据传输,提高隐私保护和系统响应速度。

未来发展趋势

自动化压缩

未来的模型压缩将更加自动化,通过神经网络架构搜索(NAS)等技术,自动找到最优的压缩方案,减少人工干预。

硬件协同设计

模型压缩将与硬件设计更加紧密地结合,开发专门针对压缩模型的AI芯片,实现软硬件协同优化。

持续学习与压缩

将压缩技术与持续学习相结合,使模型能够在资源受限的环境下不断学习和更新,适应新的任务和数据。

联邦学习中的压缩

在联邦学习场景中,模型压缩技术将帮助减少通信开销,保护数据隐私,实现多方协作训练。

结论

AI模型压缩与量化技术是推动AI落地应用的关键技术之一。通过量化、剪枝、知识蒸馏、低秩分解等多种技术,我们能够在保持模型性能的同时,显著减少模型大小和计算复杂度。随着技术的不断发展,模型压缩将变得更加高效和自动化,为AI在更多领域的应用提供支持。未来,随着硬件协同设计和持续学习等新技术的融入,模型压缩技术将迎来更加广阔的发展空间。

发表回复