AI模型部署与运维策略

随着人工智能技术的快速发展,AI模型的部署与运维已成为企业数字化转型中的关键环节。有效的部署策略和运维体系不仅能够确保模型稳定运行,还能最大化AI业务价值。本文将深入探讨AI模型部署与运维的最佳实践,帮助构建高效、可靠的AI服务系统。

部署架构设计

云原生部署架构

云原生架构已成为AI模型部署的主流选择,通过容器化、微服务化和DevOps实践,实现模型的弹性伸缩和高可用性。Kubernetes作为容器编排平台,为AI模型部署提供了强大的基础设施支持。在云原生架构中,模型通常以Docker容器形式打包,通过Kubernetes进行部署和管理。

云原生部署的优势在于:

- 资源利用率高,支持动态扩缩容

- 部署速度快,支持滚动更新和蓝绿部署

- 故障隔离性好,单个容器故障不影响整体系统

- 标准化程度高,便于跨环境迁移

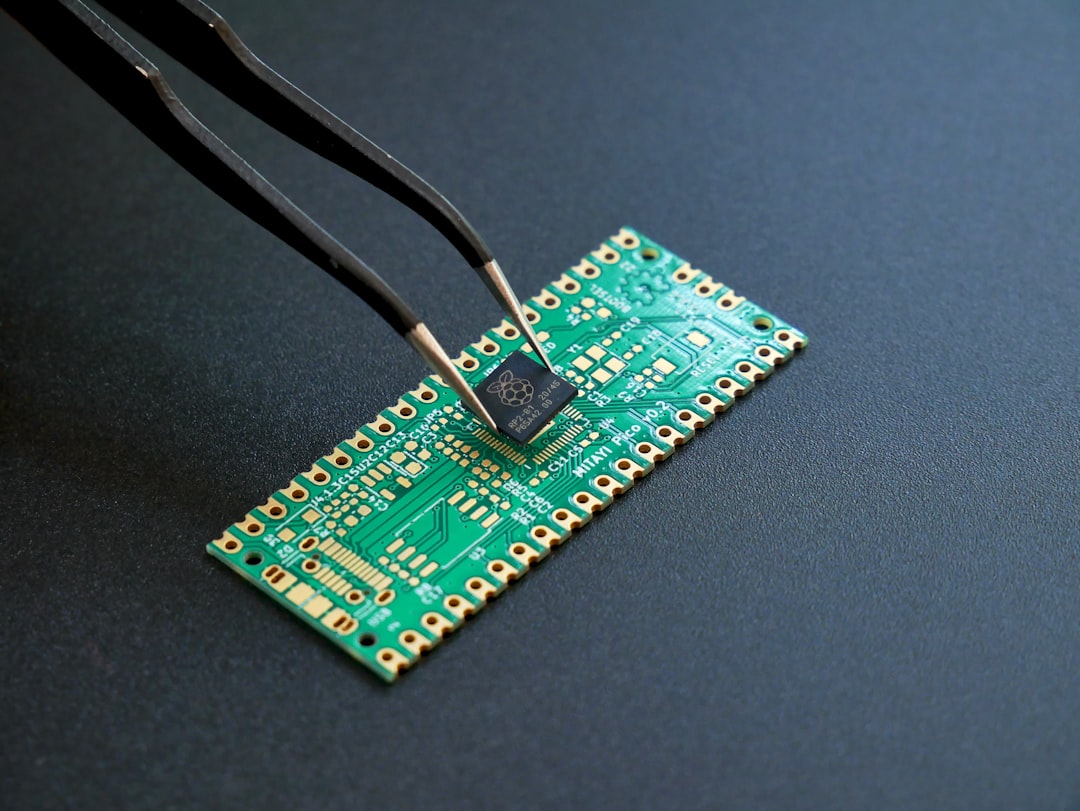

边缘计算部署

对于实时性要求高或数据隐私敏感的场景,边缘计算部署成为重要选择。边缘部署将AI模型下沉到靠近用户的边缘节点,减少网络延迟,保护数据隐私。常见的边缘部署方案包括:

- 使用TensorFlow Lite或ONNX Runtime等轻量级推理引擎

- 模型量化与压缩,减小模型体积

- 智能缓存机制,减少重复计算

- 边缘-云端协同推理架构

模型优化技术

模型压缩与量化

模型压缩是提高部署效率的关键技术,主要包括以下几种方法:

- 知识蒸馏:使用大模型指导小模型训练,在保持精度的同时减小模型尺寸

- 剪枝:移除模型中冗余的神经元或连接,减少计算量

- 量化:将模型参数从浮点数转换为低精度表示(如INT8)

- 参数共享:在不同层之间共享部分参数

量化技术特别适合边缘部署场景,可以显著减小模型体积并提升推理速度。例如,将FP32模型转换为INT8格式,模型大小可减少75%,推理速度可提升2-4倍。

硬件加速优化

充分利用硬件加速能力可以大幅提升模型推理性能。常见的硬件加速方案包括:

- GPU加速:利用NVIDIA CUDA进行并行计算

- TPU加速:Google的Tensor Processing Unit专为AI设计

- FPGA加速:现场可编程门阵列提供定制化加速方案

- ASIC加速:专用集成电路提供极致性能

针对不同硬件平台,需要选择合适的优化工具链。例如,NVIDIA的TensorRT可以优化GPU上的推理性能,Intel的OpenVINO适合CPU和FPGA加速。

监控与日志系统

模型性能监控

全面的监控系统是AI运维的基础,需要监控的关键指标包括:

- 推理延迟:端到端响应时间

- 吞吐量:每秒处理的请求数

- 资源利用率:CPU、内存、GPU使用率

- 错误率:推理失败的比例

- 模型漂移:输入数据分布变化程度

Prometheus和Grafana是构建监控系统的常用组合。Prometheus负责数据采集,Grafana负责可视化展示。通过设置告警规则,可以在指标异常时及时通知运维人员。

日志管理与分析

AI系统的日志管理需要处理大量的结构化和非结构化数据。有效的日志管理策略包括:

- 集中式日志收集:使用ELK(Elasticsearch、Logstash、Kibana)或EFK(Elasticsearch、Fluentd、Kibana)栈

- 日志分类与标签:为不同类型的日志添加有意义的标签

- 日志采样与压缩:对高频日志进行采样,减少存储压力

- 异常检测:使用机器学习技术自动识别异常日志模式

对于AI模型,特别需要关注推理日志,包括输入数据、输出结果、推理时间等关键信息,便于后续分析和调试。

自动化运维

持续集成与持续部署

CI/CD流水线是AI模型自动化运维的核心。一个完整的AI CI/CD流水线通常包含以下阶段:

- 代码提交与版本控制:使用Git进行模型代码管理

- 自动化测试:包括单元测试、集成测试和模型性能测试

- 模型训练与评估:自动化训练流程和评估指标计算

- 模型打包与部署:将模型打包为可部署格式并自动部署

- 部署验证:验证部署后的模型功能正常

Jenkins、GitLab CI、GitHub Actions等工具都可以用于构建AI CI/CD流水线。通过自动化流程,可以显著提高模型迭代效率,减少人为错误。

智能运维(AIOps)

将AI技术应用于运维领域,实现运维的智能化和自动化。AIOps的主要应用场景包括:

- 异常检测:使用机器学习算法自动检测系统异常

- 根因分析:通过关联分析快速定位故障原因

- 容量规划:基于历史数据预测资源需求

- 自愈系统:自动处理常见故障,减少人工干预

例如,通过分析历史监控数据,可以建立预测模型,提前预警可能的资源瓶颈;通过自然语言处理技术,可以自动解析日志中的错误信息,提供故障处理建议。

安全与合规

模型安全防护

AI模型面临的安全威胁主要包括模型窃取、对抗攻击、数据投毒等。有效的安全防护措施包括:

- 模型加密:对模型文件进行加密存储和传输

- 访问控制:严格的API访问认证和授权机制

- 输入验证:对模型输入进行严格验证,防止恶意输入

- 对抗检测:检测和防御对抗样本攻击

- 水印技术:在模型中嵌入水印,追踪模型泄露

API安全是模型安全的关键环节,需要实现API限流、认证、加密传输等功能,防止未授权访问和滥用。

数据隐私保护

在模型训练和推理过程中,需要严格遵守数据隐私法规。常见的数据隐私保护技术包括:

- 差分隐私:在数据中添加噪声,保护个体隐私

- 联邦学习:在数据不出本地的情况下进行模型训练

- 同态加密:对加密数据进行计算,保护原始数据

- 数据脱敏:去除或替换敏感信息

GDPR、CCPA等法规对AI系统的数据处理提出了严格要求,企业需要建立完善的数据治理体系,确保合规性。

性能调优

推理性能优化

模型推理性能直接影响用户体验和系统成本。性能优化的关键策略包括:

- 批处理优化:将多个请求合并处理,提高GPU利用率

- 模型并行:将大模型拆分为多个部分并行计算

- 流水线并行:将计算过程流水化,减少等待时间

- 动态批处理:根据系统负载动态调整批处理大小

针对特定硬件平台的优化尤为重要。例如,在GPU上使用CUDA内核优化,在CPU上使用SIMD指令集,都可以显著提升性能。

资源调度优化

合理的资源调度策略可以提高资源利用率,降低运营成本。资源调度的关键考虑因素包括:

- 负载预测:基于历史数据预测未来负载

- 弹性伸缩:根据负载自动调整资源规模

- 资源亲和性:将相关服务部署在同一节点,减少网络开销

- 多级缓存:建立多级缓存体系,减少重复计算

Kubernetes的Horizontal Pod Autoscaler(HPA)和Vertical Pod Autoscaler(VPA)可以分别实现Pod数量和资源配额的自动调整。

故障处理与恢复

故障检测与诊断

快速准确的故障检测是保障系统稳定运行的前提。故障检测的主要方法包括:

- 健康检查:定期检查模型服务的健康状态

- 依赖监控:监控模型依赖的外部服务状态

- 性能基线:建立正常性能范围,超出范围触发告警

- 异常检测:使用统计方法或机器学习检测异常行为

故障诊断需要建立完整的故障树,分析可能的原因和解决方案。例如,推理延迟可能由网络问题、资源不足或模型优化不当等原因引起。

故障恢复策略

有效的故障恢复策略可以最小化故障影响。常见的故障恢复策略包括:

- 自动重试:对暂时性故障进行自动重试

- 熔断机制:在故障率达到阈值时暂时停止服务

- 降级处理:在系统压力过大时提供简化服务

- 多活部署:在多个数据中心部署服务,实现故障转移

蓝绿部署和金丝雀发布是两种常用的零停机部署策略。蓝绿部署同时维护两个生产环境,金丝雀发布则逐步将流量切换到新版本。

未来发展趋势

MLOps成熟化

MLOps(Machine Learning Operations)正在从概念走向实践,形成完整的工程化体系。未来的MLOps将更加注重:

- 端到端自动化:从数据收集到模型部署的全流程自动化

- 实验可重现性:确保实验环境的标准化和可重现

- 模型治理:建立完善的模型生命周期管理机制

- 协作效率:提升数据科学家和工程师的协作效率

MLflow、Kubeflow等开源平台正在推动MLOps的标准化和普及,降低AI工程化的门槛。

边缘AI与云边协同

随着5G、物联网等技术的发展,边缘AI将成为重要趋势。云边协同架构将结合云端和边缘的优势:

- 云端负责模型训练和全局优化

- 边缘负责实时推理和本地决策

- 通过联邦学习实现数据隐私保护

- 通过模型同步机制保持模型一致性

边缘AI的发展将催生更多轻量级模型压缩和加速技术,以及边缘设备管理平台。

AI模型的部署与运维是一个复杂而关键的系统工程,需要综合考虑技术、管理、安全等多个维度。通过采用云原生架构、实施全面的监控、建立自动化运维体系、加强安全防护和性能优化,可以构建稳定、高效的AI服务系统。随着技术的不断发展,AI运维将更加智能化、自动化,为企业创造更大的价值。

发表回复