机器学习算法优化策略概述

机器学习算法优化是提升模型性能、降低计算成本、提高训练效率的关键环节。随着数据规模不断扩大和模型复杂度持续增加,优化策略变得愈发重要。本文将系统性地探讨各种机器学习算法优化策略,从数据预处理到模型架构,从训练过程到推理部署,全方位剖析如何构建高效、精准的机器学习系统。

数据层面的优化策略

数据预处理与特征工程

数据是机器学习的基础,数据质量直接影响模型性能。优化数据层面的策略首先要从数据预处理开始,包括缺失值处理、异常值检测、数据标准化等。特征工程则是提升模型表现的关键,通过特征选择、特征提取、特征转换等技术,可以显著减少噪声干扰,突出有效信息。

特征选择方法主要分为过滤式、包裹式和嵌入式三种。过滤式方法如卡方检验、互信息等计算速度快但可能忽略特征间的相互作用;包裹式方法如递归特征消除通过模型性能评估特征重要性,计算成本较高但效果更好;嵌入式方法如L1正则化在训练过程中自动进行特征选择,平衡了效率和效果。

数据增强与合成

数据增强是解决数据稀缺问题的有效手段。在计算机视觉领域,常用的数据增强方法包括旋转、翻转、裁剪、颜色变换等。对于文本数据,可以通过同义词替换、回译等技术扩充训练集。对于结构化数据,SMOTE算法等过采样技术可以生成合成样本,解决类别不平衡问题。

生成对抗网络(GAN)和变分自编码器(VAE)等深度学习模型能够生成高质量的合成数据,特别适用于数据稀缺的场景。这些模型通过学习真实数据的分布特征,生成与真实数据相似的样本,有效扩充了训练数据集,提高了模型的泛化能力。

模型架构优化

模型结构选择与设计

选择合适的模型架构是优化的第一步。对于不同类型的问题,需要选择不同的模型架构。对于分类问题,可以考虑逻辑回归、支持向量机、决策树等传统模型,也可以选择深度神经网络;对于回归问题,线性回归、岭回归、Lasso回归等是常见选择;对于序列数据,循环神经网络(RNN)、长短期记忆网络(LSTM)、Transformer等架构更为适合。

深度学习模型架构设计需要考虑网络深度、宽度、激活函数、连接方式等因素。ResNet、Inception、EfficientNet等先进架构通过残差连接、多尺度融合、复合缩放等技术,有效缓解了梯度消失问题,提高了模型的训练效率和性能。

模型压缩与轻量化

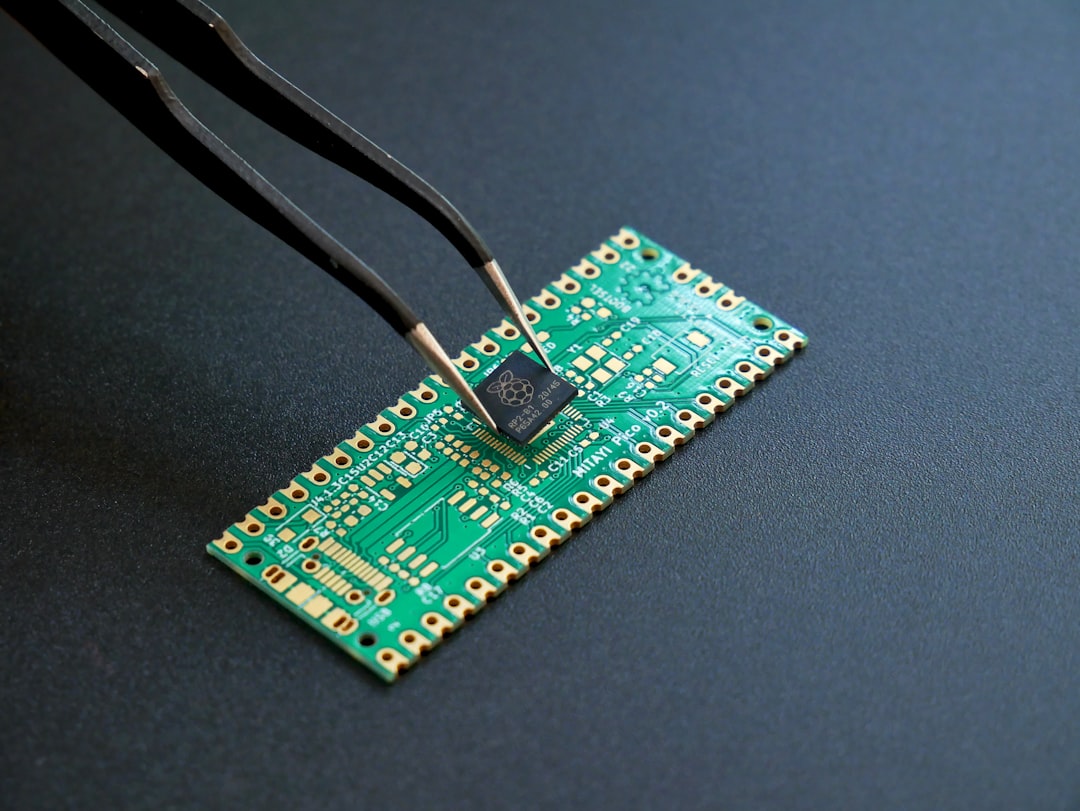

在资源受限的环境中,模型压缩变得尤为重要。模型压缩技术主要包括剪枝、量化、知识蒸馏等方法。剪枝通过移除冗余的神经元或连接,减少模型参数量;量化将浮点数转换为低精度表示,降低计算复杂度和存储需求;知识蒸馏则利用大模型(教师模型)指导小模型(学生模型)的训练,在保持性能的同时减小模型规模。

MobileNet、ShuffleNet、EfficientNet等轻量化网络架构专为移动设备和嵌入式系统设计,通过深度可分离卷积、通道混洗等技术,在保持较高精度的同时大幅降低了计算复杂度,使得深度学习能够在边缘设备上高效运行。

训练过程优化

优化算法选择

优化算法的选择直接影响模型的收敛速度和最终性能。随机梯度下降(SGD)及其变种是深度学习中最常用的优化算法。SGD虽然收敛速度较慢,但通常能找到更好的局部最优解。带动量的SGD通过累积历史梯度信息,加速了收敛过程。Adam、RMSprop等自适应学习率算法根据参数的历史梯度信息调整学习率,在不同参数维度上采用不同的学习率,提高了训练效率。

对于大规模数据集,小批量随机梯度下降(Mini-batch SGD)在计算效率和收敛稳定性之间取得了良好的平衡。批量归一化(Batch Normalization)通过规范化每一层的输入,缓解了内部协变量偏移问题,使得可以使用更高的学习率,加速训练过程。

学习率调度策略

学习率是影响模型训练最重要的超参数之一。合适的学习率调度策略可以显著提高训练效率和模型性能。常见的学习率调度策略包括:步长衰减、余弦退火、循环学习率、预热学习率等。

步长衰减按照预设的步长和衰减率调整学习率;余弦退火将学习率按照余弦函数逐渐降低;循环学习率在最小值和最大值之间周期性变化;预热学习率在训练初期逐渐增加学习率,然后按照预设策略调整。这些策略各有优劣,需要根据具体任务和模型特点选择合适的调度方法。

推理优化

模型加速与量化

模型推理阶段的优化同样重要。模型加速技术包括算子优化、内核融合、内存优化等。算子优化通过改进底层计算实现提高计算效率;内核融合将多个连续操作合并为单个操作,减少内存访问开销;内存优化通过数据布局重排和缓存优化减少内存带宽消耗。

量化是模型推理加速的有效手段。将32位浮点数转换为16位或8位整数,可以显著减少模型大小和计算复杂度。量化感知训练(Quantization-Aware Training)在训练过程中模拟量化误差,使模型能够适应低精度表示,减少量化对模型精度的影响。

硬件优化与专用加速

针对特定硬件的优化可以大幅提升推理性能。GPU通过并行计算架构加速矩阵运算,适合深度学习模型的推理;TPU(Tensor Processing Unit)是专为机器学习设计的专用芯片,具有更高的计算效率和能效比;FPGA(Field-Programmable Gate Array)通过硬件重构实现高度定制化的计算加速。

模型并行和流水线并行是处理超大模型的有效策略。模型并行将模型的不同部分分配到不同的设备上计算;流水线并行则通过重叠计算和通信时间,提高多设备训练的效率。这些技术使得训练参数量达到数十亿甚至上千亿的超大规模模型成为可能。

超参数优化

超参数搜索方法

超参数优化是提升模型性能的关键步骤。网格搜索(Grid Search)遍历所有可能的超参数组合,计算成本高但保证找到最优解;随机搜索(Random Search)在超参数空间中随机采样,通常能在更短时间内找到较好的解;贝叶斯优化通过构建超参数与性能之间的概率模型,智能地选择最有希望的参数组合,效率更高。

进化算法如遗传算法、粒子群优化等通过模拟自然选择过程,搜索最优超参数组合。这些方法特别适用于复杂的超参数空间和非凸优化问题。Hyperopt、Optuna、Scikit-Optimize等自动化超参数优化工具提供了丰富的算法实现,简化了优化过程。

自动化机器学习

自动化机器学习(AutoML)旨在减少机器学习应用中的人工干预,自动完成从数据预处理到模型部署的全流程。AutoML系统通常包括特征工程、模型选择、超参数优化、模型集成等模块。

Google的AutoML、Microsoft的Azure ML、H2O AutoML等平台提供了强大的自动化机器学习能力。这些平台能够自动探索不同的模型架构和超参数组合,找到最适合特定任务的解决方案,大大降低了机器学习的应用门槛。

正则化与防止过拟合

正则化技术

正则化是防止模型过拟合的重要手段。L1正则化(Lasso)通过添加参数绝对值之和的惩罚项,促使稀疏解的产生,实现特征选择;L2正则化(Ridge)通过添加参数平方和的惩罚项,限制参数大小,提高模型泛化能力;弹性网络(Elastic Net)结合了L1和L2正则化的优点,适用于高维数据。

Dropout是深度学习中常用的正则化技术,通过随机”丢弃”一部分神经元,防止神经元之间的共适应,提高模型的泛化能力。数据增强通过生成新的训练样本,增加了数据的多样性,也是防止过拟合的有效方法。

早停与交叉验证

早停(Early Stopping)通过监控验证集上的性能,在性能不再提升时停止训练,防止模型过拟合。交叉验证(Cross-Validation)将数据集分成多个子集,轮流使用其中一部分作为验证集,其余作为训练集,得到更稳定的性能评估。

K折交叉验证是最常用的交叉验证方法,将数据分成K个子集,每个子集都作为一次验证集。留一交叉验证(Leave-One-Out Cross-Validation)是K折交叉验证的极端情况,每次只留一个样本作为验证集,计算成本高但偏差较小。

并行化与分布式计算

数据并行与模型并行

并行化是加速大规模机器学习训练的关键策略。数据并行将数据分成多个批次,分配到不同的计算设备上,每个设备计算完整的模型梯度,然后聚合梯度更新模型参数;模型并行将模型的不同部分分配到不同的设备上,每个设备处理模型的特定部分,适用于超大模型训练。

混合并行结合了数据并行和模型并行的优点,既利用了数据并行的计算效率,又支持超大模型的训练。PyTorch的DistributedDataParallel、TensorFlow的MirroredStrategy等框架提供了便捷的并行训练实现,简化了并行编程的复杂性。

分布式训练框架

分布式训练框架是实现大规模模型训练的基础。Horovod是Uber开发的分布式训练框架,支持TensorFlow、PyTorch等主流深度学习框架,通过高效的梯度聚合和通信优化,提高了分布式训练的效率;DeepSpeed是微软开发的分布式训练优化库,提供了ZeRO(Zero Redundancy Optimizer)等技术,大幅降低了分布式训练的内存需求。

参数服务器架构是另一种常见的分布式训练模式,通过专门的参数服务器节点存储和更新模型参数,工作节点负责计算梯度。这种架构适合大规模异步训练,能够更好地处理非均匀的数据分布和设备性能差异。

实践案例与最佳实践

计算机视觉模型优化

在计算机视觉领域,模型优化通常面临精度和速度的权衡。以目标检测任务为例,YOLO系列模型通过多尺度特征融合、锚框聚类等技术,在保持较高精度的同时实现了实时检测;SSD(Single Shot MultiBox Detector)通过多尺度特征图预测不同大小的目标,平衡了检测精度和速度。

对于图像分类任务,EfficientNet通过复合缩放策略,统一缩放网络深度、宽度和分辨率,在保持模型规模的同时提高了性能;MobileNet系列通过深度可分离卷积大幅减少了计算量,适合移动设备上的实时应用。这些优化策略在实际应用中取得了显著效果。

自然语言处理模型优化

自然语言处理领域的模型优化主要集中在Transformer架构的改进上。BERT通过双向上下文表示和预训练-微调范式,显著提升了多种NLP任务的性能;GPT系列通过自回归语言建模,在文本生成、对话系统等任务中表现出色;T5将所有NLP任务统一为文本到文本的框架,简化了模型设计和训练过程。

模型蒸馏是NLP领域常用的优化技术。通过将大型预训练模型(如GPT-3)的知识转移到较小的模型上,可以在保持较高性能的同时大幅减少模型大小和计算复杂度。量化、剪枝等技术也广泛应用于NLP模型的优化,使得大规模语言模型能够在资源受限的环境中运行。

总结与展望

机器学习算法优化是一个多维度、多层次的系统工程,需要综合考虑数据、模型、训练、推理等各个环节。随着技术的不断发展,新的优化策略和方法不断涌现,如神经架构搜索(NAS)、元学习、联邦学习等,为机器学习系统的优化提供了更多可能性。

未来,机器学习优化将更加注重自动化、智能化和高效化。AutoML技术将进一步降低机器学习的应用门槛;联邦学习等隐私保护技术将在不共享原始数据的情况下实现模型优化;量子计算等新兴技术有望为机器学习优化带来革命性的突破。通过持续的技术创新和实践探索,机器学习系统将变得更加高效、智能和可靠,为各行各业带来更大的价值。

发表回复