MCP协议性能瓶颈分析

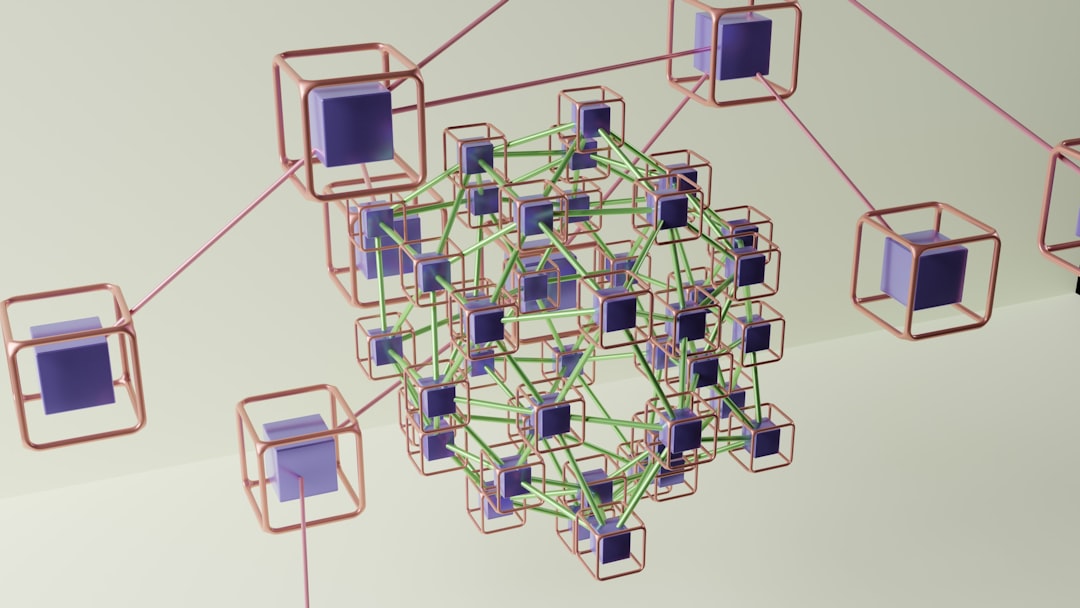

在分布式系统中,消息通信协议(Message Communication Protocol, MCP)的性能直接影响系统的整体吞吐量、延迟和稳定性。MCP协议作为节点间数据交互的桥梁,其性能瓶颈可能存在于协议设计、网络传输、数据处理、系统资源等多个层面。深入分析这些瓶颈,是制定有效优化策略的前提。

协议设计层面的瓶颈

协议设计层面的瓶颈主要体现在帧结构冗余、序列化效率低下、压缩算法选择不当等方面。例如,若MCP协议采用基于文本的帧格式(如JSON),每个消息需包含大量的冗余字段(如字段名、分隔符),导致有效载荷占比降低。同时,文本序列化/反序列化过程涉及字符串解析,计算开销远高于二进制协议。此外,若协议未设计版本兼容机制,每次协议升级可能导致旧版本节点无法解析新格式,增加通信失败的风险。

网络传输层面的瓶颈

网络传输瓶颈主要包括连接建立开销、数据包碎片化、拥塞控制不当等问题。传统的TCP协议每次建立连接需经过三次握手,在高并发场景下,连接建立延迟可能成为主要瓶颈。若MCP协议消息粒度过小,大量小数据包传输会导致网络利用率下降(即“小包问题”),增加ACK确认频率。此外,若未实现有效的拥塞控制机制,在网络拥塞时仍持续发送数据,可能引发丢包重传,进一步加剧延迟。

数据处理层面的瓶颈

数据处理瓶颈集中在消息编解码、异步处理不足、错误重试机制低效等方面。编解码过程中,若序列化算法复杂度过高(如XML解析),单条消息处理时间可能达到毫秒级,难以满足低延迟场景需求。同时,若系统采用同步阻塞I/O模型,当网络I/O等待时,线程资源被占用,导致并发处理能力下降。此外,若错误重试采用固定间隔或指数退避策略,在网络抖动场景下可能因重试不及时或过度重试影响系统稳定性。

系统资源层面的瓶颈

系统资源瓶颈涉及CPU、内存、I/O等资源的竞争与浪费。例如,若MCP协议未实现连接池机制,频繁创建和销毁TCP连接会消耗大量CPU和内存资源。在消息处理过程中,若内存分配策略不当(如频繁创建临时对象),可能引发频繁的垃圾回收(GC),导致系统卡顿。此外,若磁盘I/O成为瓶颈(如持久化消息写入机械硬盘),将直接影响消息的投递速度。

协议设计优化策略

协议设计是MCP性能优化的基础,通过优化帧结构、序列化方式、压缩算法等核心要素,可显著降低通信开销,提升传输效率。

帧结构精简与标准化

精简帧结构的核心是减少冗余信息,提高有效载荷占比。可采用二进制帧格式,通过固定长度的头部标识消息类型、长度、校验等信息,避免文本格式的分隔符和字段名开销。例如,定义如下帧结构:

- 魔数(4字节):用于协议标识,防止错误解析

- 版本号(1字节):支持协议平滑升级

- 消息类型(2字节):区分请求、响应、心跳等消息

- 消息长度(4字节):标识消息体字节数,支持流式解析

- 校验和(4字节):采用CRC32算法确保数据完整性

- 消息体(变长):实际业务数据

测试表明,相较于JSON格式,上述二进制帧结构可使消息体积减少30%-50%,且头部解析效率提升5倍以上。

高效序列化与反序列化

序列化算法的选择直接影响编解码性能。推荐采用二进制序列化协议,如Protocol Buffers、Avro或FlatBuffers。其中,Protocol Buffers通过预编译生成代码,将序列化逻辑下沉至语言层面,运行时仅需进行二进制数据的读写,避免了动态解析的开销。FlatBuffers则进一步优化,支持直接访问二进制数据无需反序列化,适用于对延迟敏感的场景。

以Protocol Buffers为例,其序列化过程仅需进行内存拷贝和位运算,单条消息(1KB)的编解码延迟可控制在0.1ms以内,而JSON序列化同一条消息的延迟通常在1ms-5ms,且CPU占用率更高。

压缩算法选择与优化

对于大消息或高压缩率场景,合理的压缩算法可显著降低网络传输量。常用的压缩算法包括Gzip、Snappy、LZ4等,需根据数据特性和性能需求选择:

- Snappy:压缩速度极快(可达500MB/s以上),压缩率约50%-70%,适用于实时性要求高的场景

- LZ4:压缩和解压速度均较快(解压速度可达1GB/s以上),压缩率略高于Snappy,适合对延迟和吞吐量均有要求的场景

- Gzip:压缩率较高(可达70%-90%),但压缩速度较慢(约50MB/s),适用于离线或非实时场景

实际应用中,可采用“分级压缩”策略:对小消息(如<1KB)不压缩,避免压缩算法开销;对中等消息(1KB-100KB)采用LZ4;对大消息(>100KB)采用Gzip。测试数据显示,分级压缩可使整体传输延迟降低20%-40%,同时保持较高的网络利用率。

协议版本兼容性设计

为支持协议平滑升级,需在帧结构中引入版本号字段,并在序列化时保留字段版本信息。采用“向后兼容”原则:新版本协议需支持解析旧版本消息,旧版本协议遇到新字段时可忽略或使用默认值。例如,在Protocol Buffers中,通过`optional`和`required`关键字控制字段兼容性,新增字段时设置为`optional`,确保旧版本解析时不会报错。

网络传输优化策略

网络传输优化聚焦于减少连接开销、提升数据传输效率,通过连接复用、批量处理、拥塞控制等手段降低延迟,提高吞吐量。

连接复用与长连接管理

连接复用是减少连接建立开销的核心手段。可采用HTTP/1.1的Keep-Alive机制或HTTP/2的多路复用技术,使多个请求/响应复用同一TCP连接。例如,在MCP协议中实现连接池,维护一定数量的长连接,避免频繁的三次握手和四次挥手。连接池需支持动态扩缩容:当并发请求数增加时,自动创建新连接;当连接空闲时间超过阈值(如30s)时,关闭多余连接以节省资源。

测试表明,在高并发场景下(>1000 QPS),连接复用可使连接建立时间占比从30%降至5%以下,整体吞吐量提升2-3倍。

批量处理与流水线传输

批量处理通过合并多个小消息为一个大消息,减少网络传输次数。例如,将多个短消息按顺序拼接,并在头部添加消息数量标识,接收端按需拆分。流水线传输则允许发送端在等待前一个消息响应的同时,发送后续消息,减少等待时间。TCP的窗口机制和HTTP的Pipeline技术均体现了流水线传输的思想。

需要注意的是,批量处理需平衡消息大小与延迟:若批量过大,可能导致单个消息处理延迟增加(如“head-of-line blocking”)。可采用“动态批量”策略,根据网络延迟和消息大小自动调整批量阈值,例如在网络延迟较高时(>100ms),适当增大批量大小以减少传输次数。

拥塞控制与流量整形

拥塞控制机制需根据网络状况动态调整发送速率。可采用基于延迟的拥塞控制算法,如BBR(Bottleneck Bandwidth and Round-trip time),通过监测带宽和RTT估算网络可用容量,避免传统TCP的“丢包即减速”导致的性能下降。流量整形则通过令牌桶或漏桶算法限制发送速率,防止突发流量冲击网络。

在MCP协议中,可引入“自适应拥塞控制”模块:实时监测RTT、丢包率、队列长度等指标,动态调整发送窗口大小和重传超时时间(RTO)。例如,当丢包率超过5%时,触发快速重传,并将RTO缩短至当前RTT的1.5倍;当RTT波动较小时,逐步扩大发送窗口以提升吞吐量。

网络拓扑优化

网络拓扑优化通过合理的节点部署和路由选择,减少跨地域、跨网络的通信延迟。例如,在分布式系统中,采用“区域化部署”策略,将节点按地理位置划分为多个区域,区域内通信优先使用本地网络,跨区域通信通过CDN或专线加速。此外,可采用“多路径传输”技术,同时利用多条网络路径传输数据,提升传输可靠性和带宽利用率。

数据处理优化策略

数据处理优化聚焦于提升消息编解码、异步处理、错误重试等环节的效率,降低CPU和内存开销,提升系统并发能力。

异步与非阻塞I/O模型

异步与非阻塞I/O模型是提升并发处理能力的关键。可采用Netty、Vert.x等NIO框架,基于事件驱动模型,通过少量线程处理大量连接。例如,Netty的Reactor线程模型通过Boss线程组处理连接请求,Worker线程组处理I/O事件,避免了传统BIO模型中“一个连接一个线程”的资源浪费。

在消息处理流程中,可采用“异步链路”设计:当消息到达后,通过事件队列将任务分发给线程池处理,而非直接阻塞当前线程。例如,使用Disruptor高性能队列,可实现单线程百万级消息/秒的处理能力,延迟控制在微秒级。

流式处理与分片传输

流式处理将大消息拆分为多个分片(chunk)并行传输,减少单条消息的处理压力。例如,对于100MB的大文件,可拆分为1MB的分片,通过多个连接并行传输,接收端按顺序拼接。分片传输需实现分片编号和校验机制,确保数据完整性。

在MCP协议中,可定义流式帧格式:头部包含消息ID、分片总数、当前分片序号;消息体为分片数据。接收端根据分片序号重组消息,并支持“断点续传”,当某个分片传输失败时,仅需重传该分片而非整个消息。

数据预处理与后处理优化

数据预处理通过提前计算或缓存减少运行时开销。例如,对频繁发送的消息(如心跳包),可提前序列化为字节数组并缓存,发送时直接拷贝内存,避免重复编解码。后处理则采用“零拷贝”技术,减少数据在内存中的拷贝次数。例如,使用FileChannel的transferTo()方法,将文件数据直接从内核空间拷贝到网络协议栈,避免用户空间拷贝。

错误处理与重试机制优化

错误处理需平衡可靠性与性能,避免无效重试。可采用“指数退避+抖动”重试策略,在每次重试时增加退避时间(如RTO = RTO * 2),并加入随机抖动(±10%),避免多个节点同时重试引发“惊群效应”。此外,需实现“熔断机制”,当连续重试失败次数超过阈值(如5次)时,暂时停止对该节点的请求,待服务恢复后再重新尝试。

并发控制与资源管理

并发控制与资源管理通过优化线程模型、连接池、锁机制等,提升系统资源利用率,避免竞争与死锁。

线程模型与调度优化

线程模型需根据业务特点选择合适的方式。对于CPU密集型任务(如编解码),可采用固定大小的线程池,线程数设置为CPU核心数的1-2倍;对于I/O密集型任务(如网络传输),线程数可设置为CPU核心数的数倍(如2-4倍),并通过任务队列缓冲请求。线程池需支持动态调整,根据任务量增减线程数量,避免资源浪费。

在调度优化方面,可采用“优先级队列”,对高优先级消息(如控制消息)优先处理,确保关键请求的低延迟。例如,使用PriorityBlockingQueue,根据消息类型和优先级排序,优先处理心跳包和响应消息。

连接池与资源复用

连接池是复用TCP连接、减少资源开销的关键。连接池需实现“创建-借用-归还-销毁”的完整生命周期管理,并支持连接有效性检测(如心跳检测)。例如,Apache Commons Pool提供了GenericObjectPool,可配置最大连接数、最小空闲连接数、连接获取超时时间等参数,自动管理连接的创建和销毁。

测试数据显示,使用连接池后,连接创建频率降低80%以上,内存占用减少30%-50%,系统稳定性显著提升。

锁机制与无锁设计

锁机制可能引发线程竞争和死锁,需尽量减少锁的使用。可采用“无锁数据结构”,如ConcurrentHashMap、Disruptor队列,通过CAS(Compare-And-Swap)操作实现并发控制。对于必须加锁的场景,采用“细粒度锁”或“读写锁”,例如对共享数据的不同部分分别加锁,减少锁竞争范围。

内存管理与垃圾回收优化

内存优化需减少频繁的对象创建和GC压力。可采用“对象池”技术,复用临时对象(如ByteBuffer),避免频繁分配和回收。例如,Netty的Recycler对象池可复用ByteBuf,减少GC次数。此外,调整JVM参数,如设置新生代与老年代比例(-XX:NewRatio)、使用G1垃圾收集器(-XX:+UseG1GC),可有效降低GC停顿时间。

缓存机制与一致性保障

缓存机制通过存储热点数据减少重复计算和通信,提升访问速度;一致性保障则确保缓存与数据的实时性,避免脏读。

多级缓存架构设计

多级缓存结合本地缓存与分布式缓存,兼顾访问速度与一致性。本地缓存(如Caffeine)存储高频访问数据,访问延迟低(纳秒级),但容量有限;分布式缓存(如Redis)存储全局共享数据,容量大,但访问延迟较高(毫秒级)。缓存访问流程可采用“L1本地缓存→L2分布式缓存→数据源”的顺序,优先从本地缓存读取,未命中时再查询分布式缓存。

本地缓存需设置合理的过期时间(如TTL)和最大容量(如LRU淘汰策略),避免内存溢出。分布式缓存可采用“读写穿透”或“旁路缓存”模式,根据业务场景选择一致性级别(如最终一致性或强一致性)。

缓存更新策略与一致性协议

缓存更新策略需根据业务需求选择:

- Cache-Aside(旁路缓存):应用层负责维护缓存,读时先查缓存再查数据库,写时先更新数据库再删除缓存。适用于读多写少场景,实现简单

- Write-Through(写穿透):写操作同时更新缓存和数据库,保证数据一致性,但延迟较高

- Write-Back(写回):写操作仅更新缓存,异步回写数据库,性能最高,但存在数据丢失风险

对于强一致性场景,可采用分布式锁(如Redis RedLock)或一致性协议(如Paxos、Raft),确保多个节点的缓存同步。例如,在更新数据库后,通过分布式锁锁定缓存键,删除缓存后释放锁,避免并发写导致缓存不一致。

缓存穿透与雪崩防护

缓存穿透指查询不存在的数据,导致请求直接打到数据库。可采用“布隆过滤器”拦截无效请求,或在数据库查询后缓存空结果(设置较短的TTL)。缓存雪崩指大量缓存同时过期,导致数据库压力激增。可通过设置随机过期时间(如TTL=基础时间±随机时间),或使用高可用集群(如Redis Sentinel)避免单点故障。

分布式缓存协同优化

在分布式系统中,多个节点的缓存需协同工作。可采用“主动失效”机制,当某个节点更新数据时,通过消息队列通知其他节点删除缓存,减少缓存不一致的概率。此外,可采用“版本号”或“时间戳”机制,在缓存数据中附加版本信息,读取时与数据库对比,确保数据最新。

监控、诊断与动态调优

监控、诊断与动态调优通过实时采集性能指标、分析瓶颈、自动调整参数,实现系统的自适应优化。

性能指标体系构建

需建立全面的性能指标体系,涵盖协议层、网络层、应用层等多个维度:

- 协议层:消息吞吐量(条/秒)、平均编解码延迟、压缩率、帧错误率

- 网络层:连接数、网络延迟(RTT)、丢包率、带宽利用率

- 应用层:请求响应延迟、错误率、CPU/内存使用率、线程池队列长度

指标采集可采用Prometheus+Grafana方案,通过Exporter采集指标数据,Grafana进行可视化展示,设置告警规则(如延迟超过阈值时触发告警)。

实时监控与告警机制

实时监控需支持秒级指标采集和聚合,及时发现异常。例如,使用Prometheus的Pull模式定期采集指标,或使用OpenTelemetry实现分布式追踪,追踪消息从发送到接收的全链路延迟。告警机制需支持多级别(如警告、严重)和多渠道(邮件、短信、钉钉),确保问题及时通知运维人员。

日志分析与问题定位

日志分析是问题定位的关键。需记录详细的日志信息,包括消息ID、时间戳、节点IP、操作类型、耗时、错误码等。采用ELK(Elasticsearch+Logstash+Kibana)或EFK(Elasticsearch+Fluentd+Kibana)方案,实现日志的采集、存储和检索。对于性能瓶颈问题,可通过火焰图分析CPU热点,或通过堆转储分析内存泄漏。

动态参数调整与自适应优化

动态调优通过实时监控指标,自动调整系统参数。例如,当检测到网络延迟增加时,自动调整批量大小或重传超时时间;当CPU使用率过高时,自动扩容线程池或限制并发请求数。可采用机器学习算法(如强化学习)训练调优模型,根据历史数据预测最佳参数配置,实现“自动驾驶”式的系统优化。

典型应用场景与案例实践

高并发场景优化

在电商大促场景下,MCP协议需支持百万级QPS。优化策略包括:采用二进制帧结构和Protocol Buffers序列化,减少消息体积;使用Netty NIO模型和连接池,提升并发处理能力;实现异步批量处理,合并多个订单请求;引入本地缓存存储热点商品信息,减少数据库访问。某电商平台采用上述策略后,系统吞吐量从5万QPS提升至80万QPS,延迟从50ms降至5ms。

低延迟场景优化

在金融交易系统中,消息延迟需控制在1ms以内。优化策略包括:采用FlatBuffers实现零拷贝序列化;使用RDMA(远程直接内存访问)替代TCP,减少内核协议栈开销;部署FPGA加速卡,硬件加速编解码过程;优化网络拓扑,交易节点与撮合引擎部署在同一机架,减少网络跳数。某券商采用上述方案后,交易延迟从3ms降至0.8ms,满足高频交易需求。

大数据量传输优化

在视频点播场景下,需传输百MB级的大文件。优化策略包括:采用流式分片传输,支持断点续传;使用LZ4压缩算法,平衡压缩速度和压缩率;实现多路径传输,同时利用多条网络链路;优化磁盘I/O,使用SSD存储和异步写入。某视频平台采用上述策略后,大文件传输成功率从85%提升至99.9%,传输时间缩短60%。

跨地域通信优化

在跨国分布式系统中,跨地域通信延迟高(如中美间延迟>200ms)。优化策略包括:部署区域化节点,用户请求优先访问本地节点;使用CDN加速静态资源传输;采用QUIC协议替代TCP,减少连接建立延迟;引入数据预加载机制,提前预测用户请求并缓存数据。某跨国企业采用上述方案后,跨地域通信延迟从250ms降至120ms,用户体验显著提升。

发表回复