标签: 自注意力

-

Transformer架构核心机制深度解析

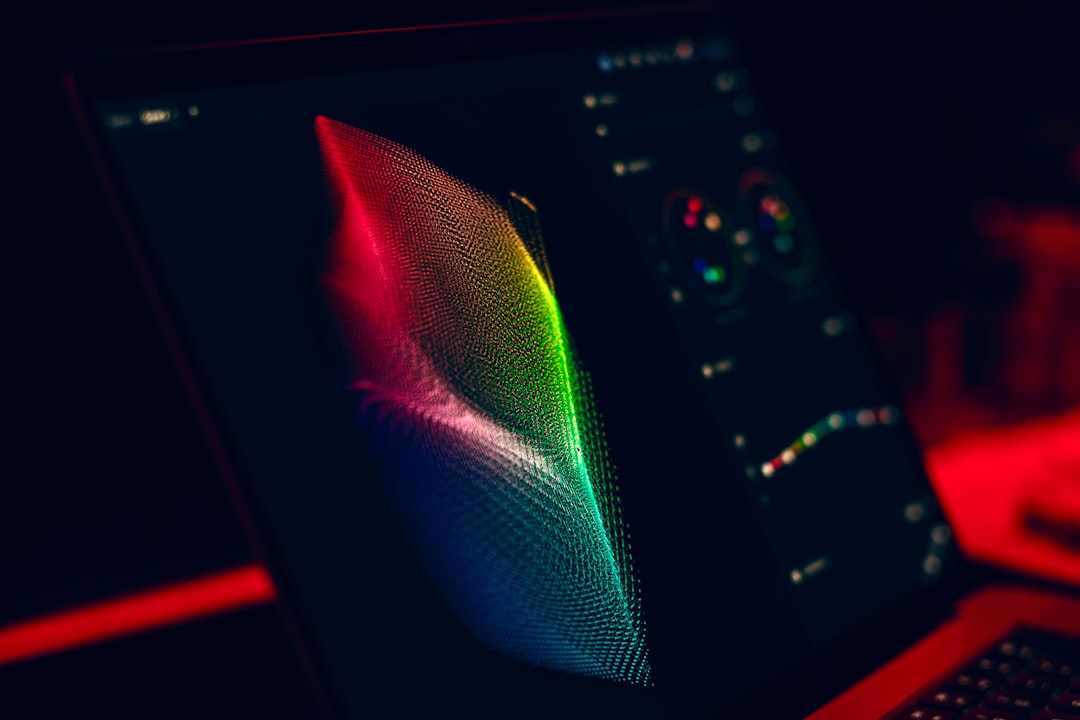

Transformer架构作为序列建模的核心范式,其核心机制在于自注意力机制,通过动态计算序列元素间依赖关系解…

-

Transformer架构核心机制深度解析

Transformer架构凭借自注意力机制革新序列建模,通过多头注意力捕捉长距离依赖,位置编码融入序列顺序信息…

-

Transformer架构核心机制深度解析

本文深度剖析Transformer架构核心机制,详解自注意力与多头注意力的数学原理及并行优势,阐释位置编码对序…